Unter dem »Internet der Dinge (IoT)« versteht man die Vernetzung von einer Vielzahl verschiedener intelligenter (eng.: smart) Sensoren, Geräten und Systemen, die innerhalb eines IP-Netzes kommunizieren.

Diese Systeme erzeugen und versenden ständig große Datenmengen, vor allem Umgebungs- und Zustandsdaten, welche adäquat integriert, verarbeitet und im richtigen Umfang gespeichert werden müssen.

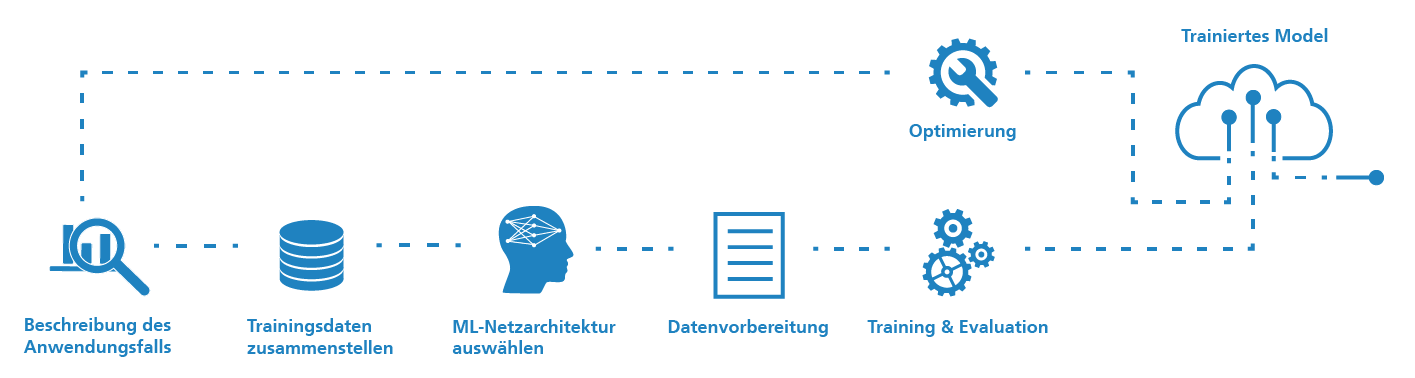

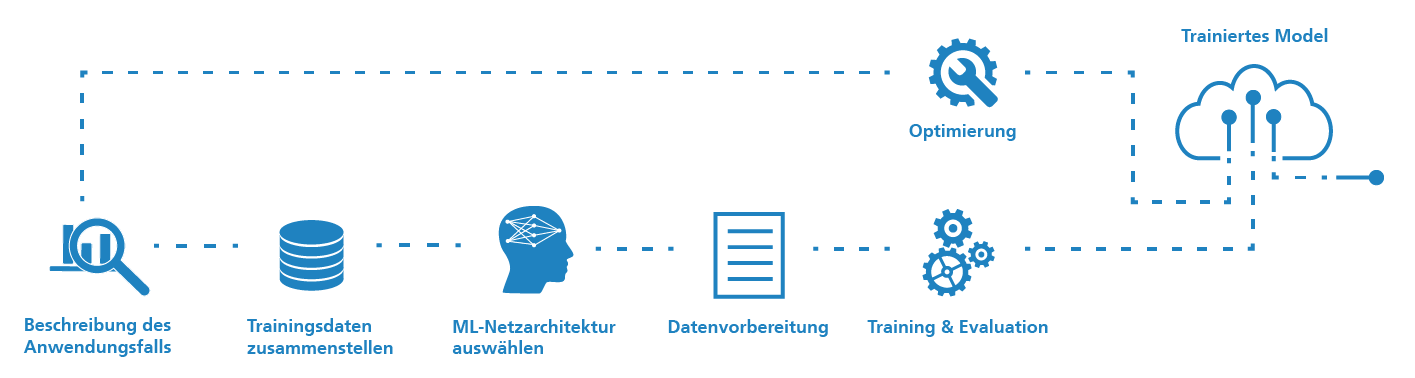

Hier eröffnet das Internet of Things (IoT) neue Möglichkeiten: Durch die Vernetzung von Echtzeit-Daten mit dem Ziel der effizienten Verwaltung und Integration in logistische Systeme werden Lösungselemente wie Machine Learning und Data Analytics angewendet, um z.B. eine Zustandsüberwachung, Analyse oder Automatisierung von logistischen Prozessen zu erreichen.